Bases Vectoriales: El GPS del Conocimiento que Alimenta a ChatGPT y Copilot

26 JUL., 2025

//4 min. de Lectura

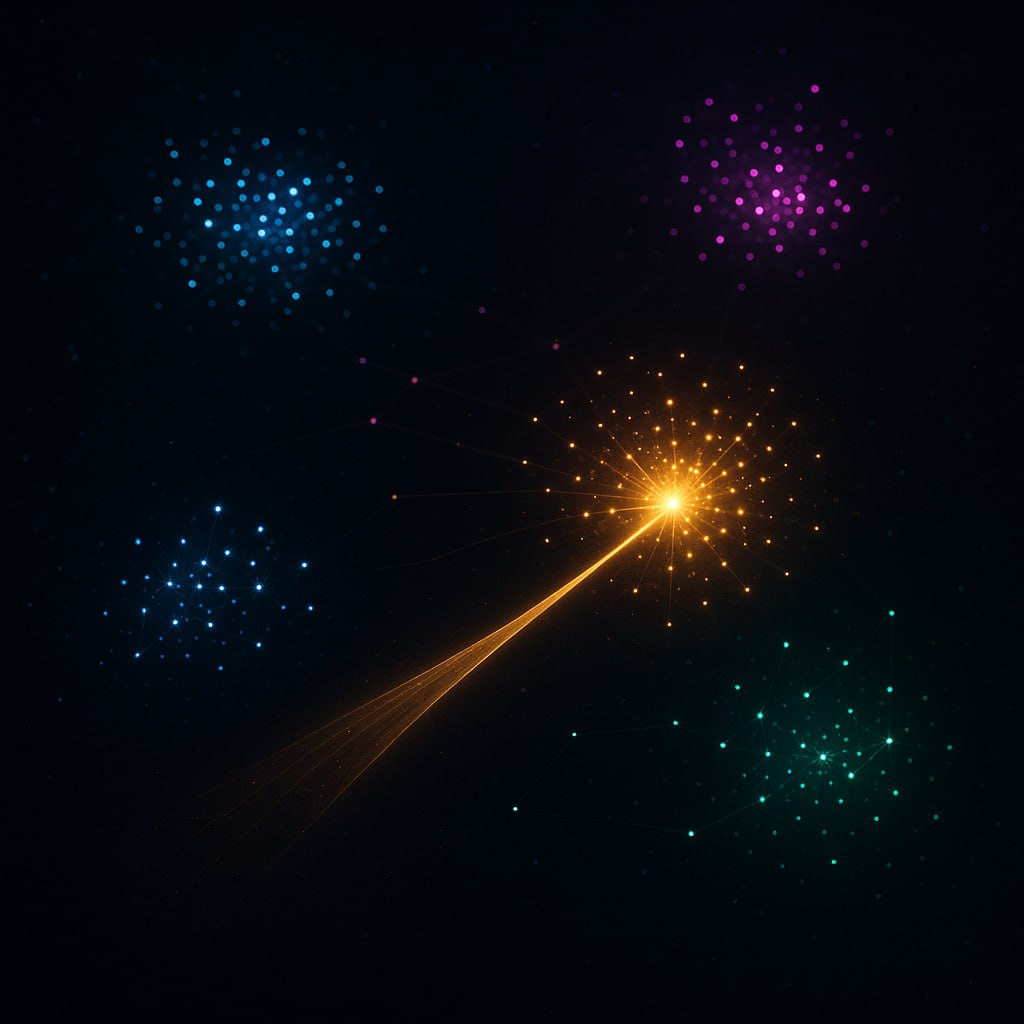

¿Cómo encuentra GPT-4 en milisegundos esa cita perdida en 10TB de textos? La magia está en los vectores, no en SQL. En el corazón de la revolución de IA generativa late una tecnología poco conocida pero fundamental: las bases de datos vectoriales. Hoy exploraremos cómo estos sistemas funcionan como el GPS del conocimiento, permitiendo a los modelos de lenguaje navegar por océanos de información con precisión milimétrica.

El Problema Fundamental: Buscar una Aguja en un Pajar de 10TB

Los modelos como GPT-4 contienen conocimiento pero no memoria. Cuando les preguntas sobre eventos recientes o documentos específicos, enfrentan un desafío monumental:

- No pueden almacenar toda la Wikipedia en sus parámetros

- Buscar en texto plano sería como encontrar una aguja en un pajar de 10TB

- Las bases de datos tradicionales fallan con datos no estructurados

- Las consultas semánticas ("conceptos similares") son imposibles con SQL

La solución llegó con una innovación: transformar el conocimiento en geometría. Así nacieron las bases vectoriales, el GPS que guía a los LLMs a través del espacio del conocimiento.

Arquitectura Secreta: Embeddings + Bases Vectoriales = Cerebro Completo

Los LLMs modernos combinan dos tecnologías para simular memoria a largo plazo:

1. Embeddings

Modelos como text-embedding-ada-002 convierten texto en vectores:

"revolución industrial" → [0.76, -1.24, 0.33, ..., 0.92]

"innovación tecnológica" → [0.81, -1.18, 0.38, ..., 0.87]

Distancia coseno: 0.02 (conceptos cercanos)

2. Bases Vectoriales

Sistemas como Pinecone o Weaviate:

- Almacenan billones de vectores indexados

- Buscan vecinos más cercanos en milisegundos

- Escalan horizontalmente en la nube

Juntos forman la memoria externa de los LLMs. Mientras el modelo maneja el razonamiento, la base vectorial provee el conocimiento relevante al instante.

El Viaje de una Consulta: De Pregunta a Respuesta en 200ms

Veamos cómo funciona el proceso cuando preguntas a ChatGPT sobre "las consecuencias económicas de la Revolución Industrial":

Detalles técnicos de cada etapa:

- Embedding: La consulta se transforma en vector en ~50ms

- Búsqueda aproximada (ANN): Algoritmos como HNSW encuentran los 10 vecinos más cercanos en 100ms

- Reranking: Modelo cruzado reordena resultados por relevancia

- Inyección de contexto: Los documentos relevantes se insertan en el prompt del LLM

Caso Real: 70% de Ahorro en Costos de Inferencia

Una empresa de SaaS implementó asistentes IA para su plataforma. Inicialmente usaban fine-tuning de GPT-3.5 para conocimiento específico. Tras migrar a base vectorial (Pinecone) + embeddings, lograron:

Solución Antigua (Fine-tuning)

- Costo mensual: $28,000

- Latencia: 850ms por consulta

- Actualización de conocimiento: Cada 72 horas

- Precisión: 78%

- Tokens usados: 4,500/consulta

Solución Nueva (Vector DB)

- Costo mensual: $8,400 (70% menos)

- Latencia: 210ms por consulta

- Actualización de conocimiento: En tiempo real

- Precisión: 92%

- Tokens usados: 1,200/consulta

Cómo lo lograron: En lugar de ajustar el modelo completo, implementaron:

from openai import OpenAI

import pinecone

client = OpenAI()

pinecone.init(api_key="YOUR_KEY")

def query_knowledge_base(question):

# Paso 1: Crear embedding de la pregunta

embedding = client.embeddings.create(

input=question,

model="text-embedding-3-small"

).data[0].embedding

# Paso 2: Buscar en base vectorial

results = pinecone.Index("knowledge-base").query(

vector=embedding,

top_k=5,

include_metadata=True

)

# Paso 3: Construir contexto

context = "\n".join([match.metadata['text'] for match in results.matches])

# Paso 4: Generar respuesta con contexto

response = client.chat.completions.create(

model="gpt-4-turbo",

messages=[

{"role": "system", "content": "Responde usando este contexto:\n" + context},

{"role": "user", "content": question}

]

)

return response.choices[0].message.content

El Ecosistema Emergente: Herramientas que Están Cambiando el Juego

El mercado de bases vectoriales está creciendo exponencialmente:

Pinecone

Líder en soluciones empresariales gestionadas

Weaviate

Open-source con capacidades híbridas (vector + texto)

Chroma

Ligero y open-source para proyectos pequeños

Innovaciones recientes:

- Multi-modalidad: Búsqueda conjunta de texto, imagen y audio

- Híbridos SQL/Vector: PostgreSQL con pgvector y MySQL con Vector Index

- Caching vectorial: Redis como base vectorial de alto rendimiento

- Fine-tuning adaptativo: Bases que aprenden de las interacciones

Conclusión: El Futuro es Vectorial

Las bases vectoriales han resuelto el problema fundamental de los LLMs: cómo acceder a conocimiento específico sin sacrificar eficiencia. Como hemos explorado:

- Transforman conocimiento en geometría: Mapean significado en espacios multidimensionales

- Reducen costos radicalmente: Hasta 70% menos que el fine-tuning tradicional

- Permiten búsquedas semánticas: Encontrar por significado, no por palabras clave

- Actualizan conocimiento en tiempo real: A diferencia de modelos estáticos

En los próximos años, veremos esta tecnología expandirse más allá de los LLMs:

- Motores de recomendación 3.0: Que entienden preferencias conceptuales

- Búsqueda empresarial: Encontrar documentos por significado, no por keywords

- Diagnóstico médico: Relacionando síntomas con vectores de enfermedades

- Detección de fraude: Identificando patrones en espacios vectoriales

Las bases vectoriales son el GPS que guía a la IA a través del vasto océano del conocimiento humano. Mientras los modelos de lenguaje son los motores, estas bases son el sistema de navegación que les permite llegar exactamente donde necesitan, en milisegundos, con la precisión de un rayo láser. En la era de la información, dominar los vectores es dominar el acceso al conocimiento.

Comentarios

0Sin comentarios

Sé el primero en compartir tu opinión.

También te puede interesar

Descubre más contenido relacionado que podría ser de tu interés

One-Hot Encoding: La Técnica Esencial para Modelar el Lenguaje Natural

exploraremos qué es el one-hot encoding, cómo funciona, sus aplicaciones en NLP

Semantic Search 2.0: Cómo Mercado Libre Rediseñó su Búsqueda con Vectores (y Aplastó a Google)

la batalla por la búsqueda perfecta se ha decidido con una tecnología revolucionaria: la búsqueda semántica vectorial