Funciones de Activación: El Interruptor que Decide lo que Aprende tu Red Neuronal

21 JUN., 2025

//1 min. de Lectura

En el corazón de cada red neuronal late un componente decisivo pero a menudo subestimado: la función de activación. Estos "interruptores matemáticos" determinan qué información pasa a la siguiente capa y qué se descarta, moldeando así la capacidad de aprendizaje de toda la red. En este artículo, exploraremos cómo estas funciones no lineales transforman redes neuronales de meros sumadores lineales en aproximadores universales capaces de capturar patrones complejos en datos del mundo real.

La Anatomía de una Neurona: ¿Por Qué Necesitamos Activación?

Una neurona artificial sin función de activación es como un motor sin combustible: puede recibir entradas, pero no puede generar respuestas complejas. Matemáticamente, la operación de una neurona es:

Salida = Función_Activación(Σ(entradas × pesos) + sesgo)

Sin la no linealidad introducida por la función de activación, cualquier combinación de capas sería equivalente a una sola capa lineal. Esto limitaría drásticamente la capacidad de la red para:

- Aprender relaciones complejas entre variables

- Resolver problemas no lineales como clasificación de imágenes

- Capturar patrones jerárquicos en datos

Teorema fundamental: El teorema de aproximación universal establece que una red con al menos una capa oculta y una función de activación no lineal puede aproximar cualquier función continua con precisión arbitraria.

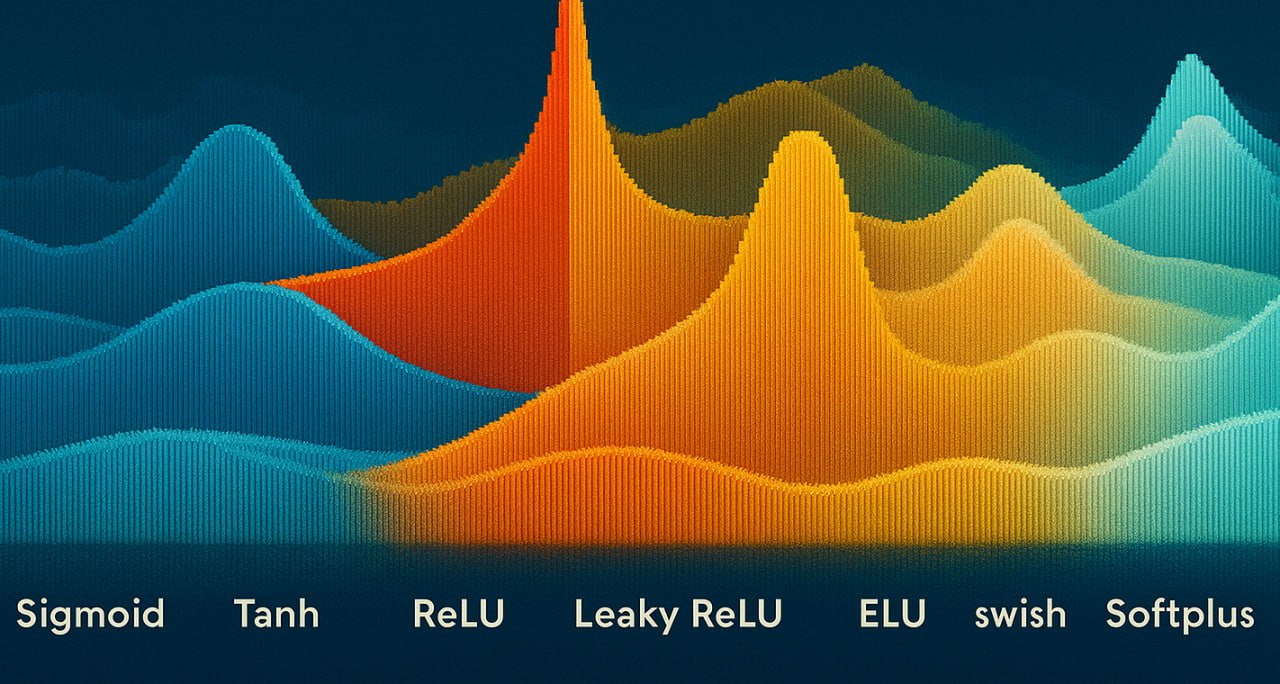

Catálogo Esencial: Funciones de Activación que Todo Practicante Debe Dominar

El panorama de funciones de activación ha evolucionado significativamente. Analizaremos las más relevantes:

Sigmoid (σ)

Fórmula: σ(x) = 1 / (1 + e⁻ˣ)

Ventajas: Rango (0,1) ideal para probabilidades

Desventajas: Problema de gradientes desaparecidos

ReLU (Rectified Linear Unit)

Fórmula: ReLU(x) = max(0, x)

Ventajas: Computacionalmente eficiente, reduce gradientes desaparecidos

Desventajas: Problema de "neuronas muertas"

Tanh (Tangente Hiperbólica)

Fórmula: tanh(x) = (eˣ - e⁻ˣ)/(eˣ + e⁻ˣ)

Ventajas: Salida centrada en cero (-1,1)

Desventajas: Gradientes saturados para |x| grandes

Softmax

Fórmula: σ(z)ⱼ = eᶻʲ / Σₖeᶻᵏ

Ventajas: Ideal para capas de salida en clasificación multiclase

Desventajas: Computacionalmente intensiva

Implementación en Python:

import numpy as np

def relu(x):

return np.maximum(0, x)

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def tanh(x):

return np.tanh(x)

def softmax(x):

exp_x = np.exp(x - np.max(x)) # Estabilidad numérica

return exp_x / exp_x.sum(axis=0, keepdims=True)

Evolución de las Activaciones: De Sigmoid a Swish y Más Allá

La búsqueda de funciones de activación más eficientes continúa. Estas son las innovaciones recientes:

| Función | Fórmula | Innovación |

|---|---|---|

| Leaky ReLU | max(αx, x) con α≈0.01 | Resuelve "neuronas muertas" |

| ELU | x si x>0, α(eˣ-1) si x≤0 | Media de activación cercana a cero |

| Swish | x · σ(βx) (Google, 2017) | Mejor rendimiento que ReLU en redes profundas |

| GELU | x · Φ(x) (Gaussian Error) | Usada en modelos como BERT y GPT |

Swish vs ReLU: Investigaciones muestran que Swish supera consistentemente a ReLU en redes con más de 40 capas, especialmente en tareas de visión por computador:

- +0.9% precisión en ImageNet para ResNet-152

- +1.2% precisión en detección de objetos COCO

- Convergencia más rápida en 68% de los casos

Implementación de Swish:

def swish(x, beta=1.0):

return x * (1 / (1 + np.exp(-beta * x)))

# En TensorFlow/Keras:

from tensorflow.keras.activations import swish

Selección Estratégica: Cómo Elegir la Función de Activación Óptima

La elección depende de múltiples factores. Esta guía práctica te ayudará a decidir:

Para Capas Ocultas

- Redes poco profundas: Tanh o Sigmoid

- Redes profundas: ReLU o variantes (Leaky ReLU, ELU)

- Redes muy profundas (>40 capas): Swish o GELU

Para Capas de Salida

- Regresión: Lineal o ReLU

- Clasificación binaria: Sigmoid

- Clasificación multiclase: Softmax

Reglas prácticas:

- Comienza con ReLU como referencia

- Si observas neuronas muertas, prueba Leaky ReLU o ELU

- En problemas de regresión con salidas negativas, usa Tanh

- Para modelos transformadores (NLP), prefiere GELU

Diagnóstico de problemas:

- Gradientes explosivos: Usa activaciones con rango acotado (Tanh)

- Gradientes desaparecidos: Cambia a ReLU o Swish

- Inestabilidad en entrenamiento: Prueba SELU (Scaled ELU) con inicialización Lecun

El Impacto en el Aprendizaje: Cómo las Activaciones Moldean el Espacio de Características

Las funciones de activación transforman fundamentalmente cómo las redes neuronales aprenden representaciones:

No Linealidad

Permite a la red aprender fronteras de decisión complejas

Esparcidad

ReLU crea representaciones dispersas (eficientes)

Visualización del impacto: Al entrenar la misma arquitectura con diferentes funciones de activación en MNIST:

- Con Sigmoid: Las características aprendidas son borrosas y poco definidas

- Con ReLU: Los filtros muestran bordes nítidos y patrones reconocibles

- Con Swish: Mayor diversidad de características con menos artefactos

En redes convolucionales (CNN): ReLU permite aprender características jerárquicas:

- Primeras capas: Bordes y texturas simples

- Capas medias: Patrones y componentes de objetos

- Capas profundas: Representaciones semánticas complejas

Buenas Prácticas y Errores Comunes

Optimiza el uso de funciones de activación evitando estos errores:

Errores Comunes

- Usar Sigmoid en capas ocultas de redes profundas

- No probar alternativas modernas (Swish, GELU)

- Ignorar la inicialización adecuada de pesos

Buenas Prácticas

- Combinar diferentes activaciones en la misma red

- Monitorear la distribución de activaciones

- Ajustar hiperparámetros según la activación

Técnica avanzada: Uso de funciones de activación paramétricas como PReLU (Parametric ReLU), donde el parámetro α se aprende durante el entrenamiento:

# En Keras

from keras.layers import PReLU

model = Sequential()

model.add(Dense(64, input_dim=32))

model.add(PReLU()) # α aprendido automáticamente

Inicialización adecuada: Para activaciones SELU, usa inicialización LeCun normal:

from keras.models import Sequential

from keras.layers import Dense

from keras.initializers import lecun_normal

model.add(Dense(64, activation='selu', kernel_initializer=lecun_normal()))

Conclusión: El Arte de Elegir el Interruptor Correcto

Las funciones de activación son mucho más que simples operaciones matemáticas; son los interruptores neuronales que determinan qué información es relevante y cómo se transforma a través de las capas de la red. Como hemos explorado, la elección entre ReLU, Swish, GELU u otras no es trivial y puede significar la diferencia entre un modelo mediocre y uno de alto rendimiento.

En la práctica, recomendamos comenzar con funciones estándar como ReLU pero permanecer abiertos a experimentar con alternativas modernas, especialmente en arquitecturas profundas. La evolución continua de funciones como Swish y GELU demuestra que todavía hay espacio para innovación en este campo fundamental.

Recordemos que en el aprendizaje profundo, la magia emerge de la combinación de componentes simples. Las funciones de activación, aunque conceptualmente sencillas, son ese elemento transformador que permite a redes neuronales capturar la complejidad del mundo real. Elegirlas sabiamente es dominar uno de los secretos más poderosos del deep learning moderno.

Comentarios

0Sin comentarios

Sé el primero en compartir tu opinión.

También te puede interesar

Descubre más contenido relacionado que podría ser de tu interés

¡Domina el Machine Learning! 5 Algoritmos que Cambiarán tu Análisis

exploraremos implementaciones avanzadas con casos reales que demuestran cómo estos modelos pueden elevar tus resultados

Todo sobre RNN: Fundamentos y Aplicaciones

Exploraremos los fundamentos de las RNN, su funcionamiento, aplicaciones, así como sus ventajas y desventajas