Introducción a las Redes Neuronales con TensorFlow/Keras: Guía Completa para Principiantes

Aprende redes neuronales con TensorFlow y Keras. Guía paso a paso para principiantes con ejemplos prácticos en Python.

¡Da tus primeros pasos en las redes neuronales con TensorFlow y Keras! En este tutorial completo te guiaré paso a paso para que aprendas los fundamentos de las redes neuronales y construyas tu primer modelo de deep learning.

Objetivo: Aprender los conceptos básicos de las redes neuronales y cómo implementar modelos simples usando TensorFlow/Keras.

Paso 1: ¿Qué son las Redes Neuronales?

Las redes neuronales son modelos computacionales inspirados en el cerebro humano que pueden aprender patrones complejos desde los datos. Son la base del aprendizaje profundo (deep learning).

# Importar librerías esenciales

import tensorflow as tf

from tensorflow import keras

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

# Configuración

tf.random.set_seed(42)

np.random.seed(42)

sns.set_style("whitegrid")

plt.rcParams['figure.figsize'] = (10, 6)Paso 2: Primer Contacto: Dataset MNIST

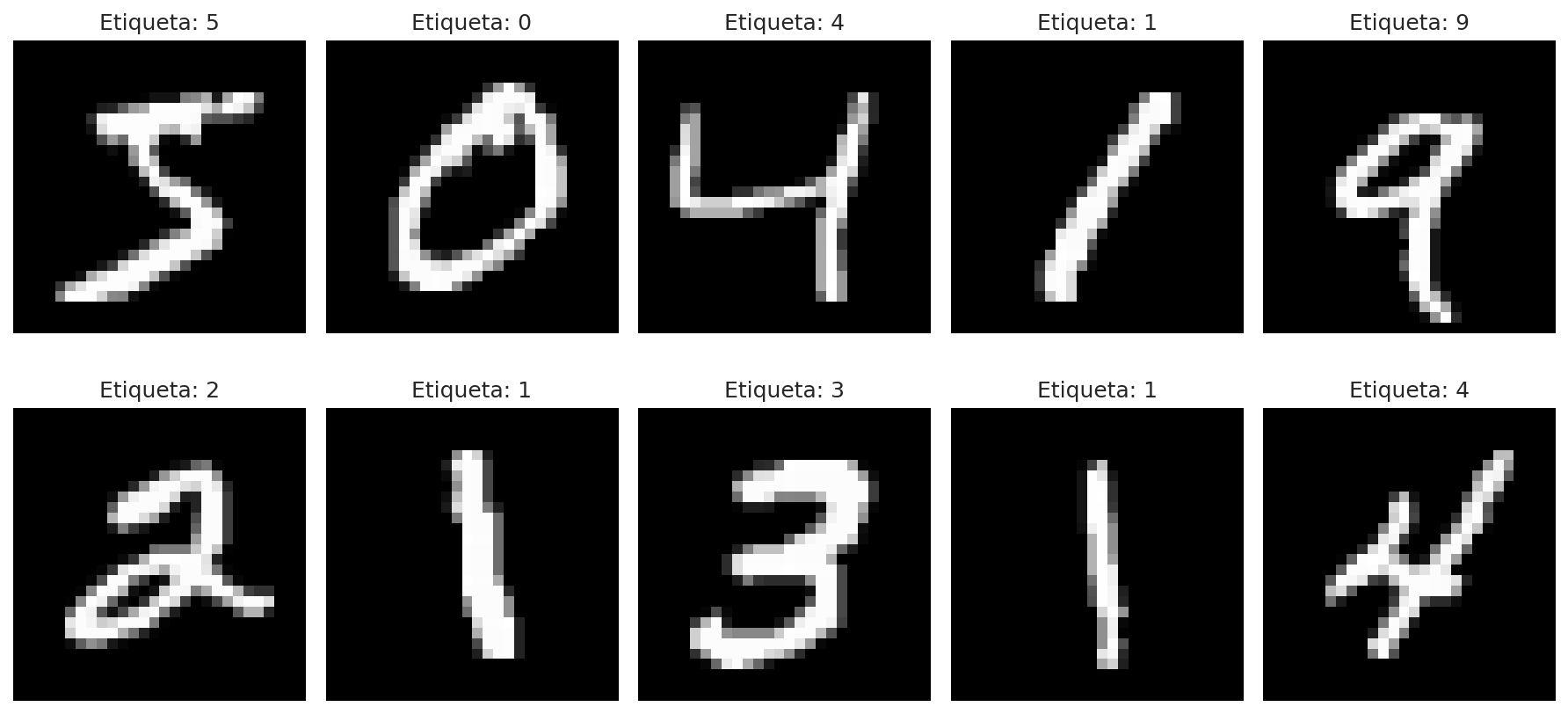

Vamos a trabajar con el dataset clásico de dígitos escritos a mano.

# Cargar dataset MNIST

(X_train, y_train), (X_test, y_test) = keras.datasets.mnist.load_data()

print(f"Forma de X_train: {X_train.shape}")

print(f"Forma de y_train: {y_train.shape}")

print(f"Valores únicos en y_train: {np.unique(y_train)}")

# Visualizar algunos ejemplos

plt.figure(figsize=(12, 6))

for i in range(10):

plt.subplot(2, 5, i + 1)

plt.imshow(X_train[i], cmap='gray')

plt.title(f'Etiqueta: {y_train[i]}')

plt.axis('off')

plt.tight_layout()

plt.show()

Paso 3: Preprocesamiento de Datos

# Normalizar los valores de píxeles (0-255 → 0-1)

X_train = X_train / 255.0

X_test = X_test / 255.0

# Reformatear para redes neuronales (añadir dimensión de canal)

X_train = X_train.reshape(-1, 28, 28, 1)

X_test = X_test.reshape(-1, 28, 28, 1)

# Convertir etiquetas a one-hot encoding

y_train_categorical = keras.utils.to_categorical(y_train, 10)

y_test_categorical = keras.utils.to_categorical(y_test, 10)

print(f"Nueva forma de X_train: {X_train.shape}")

print(f"Forma de y_train_categorical: {y_train_categorical.shape}")Paso 4: Construyendo tu Primera Red Neuronal

Arquitectura Básica

model = keras.Sequential([

# Capa de entrada - aplanar imagen 28x28 a vector de 784 elementos

keras.layers.Flatten(input_shape=(28, 28, 1)),

# Primera capa oculta - 128 neuronas con activación ReLU

keras.layers.Dense(128, activation='relu'),

# Segunda capa oculta - 64 neuronas

keras.layers.Dense(64, activation='relu'),

# Capa de salida - 10 neuronas (una por cada dígito) con activación softmax

keras.layers.Dense(10, activation='softmax')

])

# Resumen de la arquitectura

model.summary()Compilación del Modelo

model.compile(

optimizer='adam', # Optimizador

loss='categorical_crossentropy', # Función de pérdida

metrics=['accuracy'] # Métricas a monitorizar

)Paso 5: Entrenamiento de la Red Neuronal

# Entrenar el modelo

history = model.fit(

X_train, y_train_categorical,

epochs=10,

batch_size=32,

validation_split=0.2, # Usar 20% para validación

verbose=1

)Paso 6: Evaluación del Modelo

# Evaluar en el conjunto de prueba

test_loss, test_accuracy = model.evaluate(X_test, y_test_categorical, verbose=0)

print(f"\nPrecisión en prueba: {test_accuracy:.4f}")

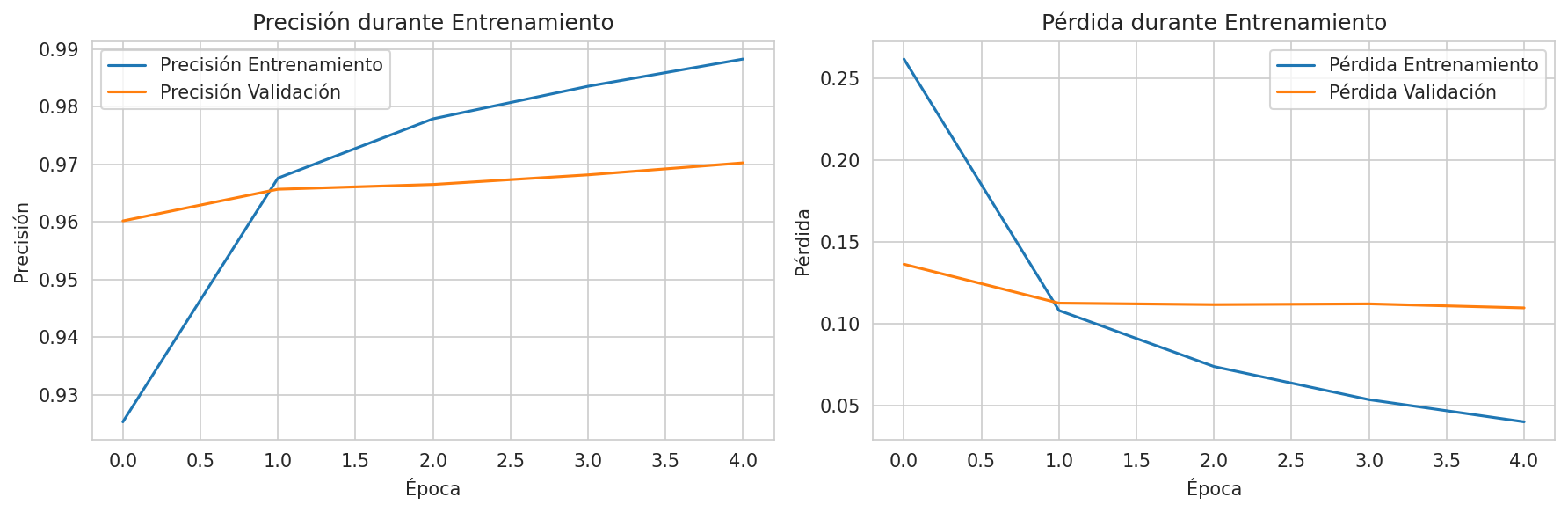

# Visualizar histórico de entrenamiento

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.plot(history.history['accuracy'], label='Precisión Entrenamiento')

plt.plot(history.history['val_accuracy'], label='Precisión Validación')

plt.title('Precisión durante Entrenamiento')

plt.xlabel('Época')

plt.ylabel('Precisión')

plt.legend()

plt.subplot(1, 2, 2)

plt.plot(history.history['loss'], label='Pérdida Entrenamiento')

plt.plot(history.history['val_loss'], label='Pérdida Validación')

plt.title('Pérdida durante Entrenamiento')

plt.xlabel('Época')

plt.ylabel('Pérdida')

plt.legend()

plt.tight_layout()

plt.show()

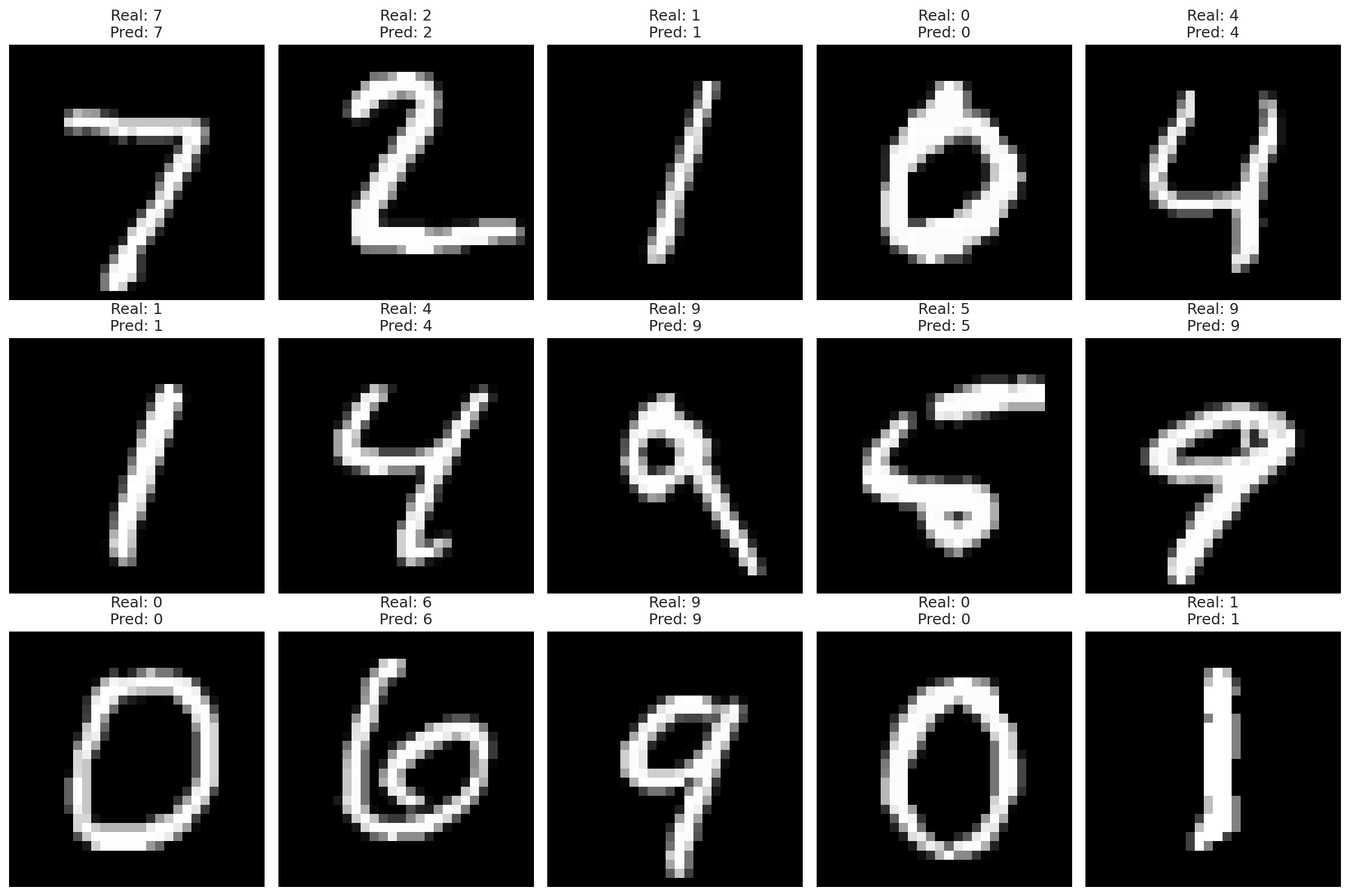

Paso 7: Haciendo Predicciones

# Predecir sobre el conjunto de prueba

predictions = model.predict(X_test)

predicted_classes = np.argmax(predictions, axis=1)

# Visualizar algunas predicciones

plt.figure(figsize=(15, 10))

for i in range(15):

plt.subplot(3, 5, i + 1)

plt.imshow(X_test[i].reshape(28, 28), cmap='gray')

plt.title(f'Real: {y_test[i]}\nPred: {predicted_classes[i]}')

plt.axis('off')

plt.tight_layout()

plt.show()

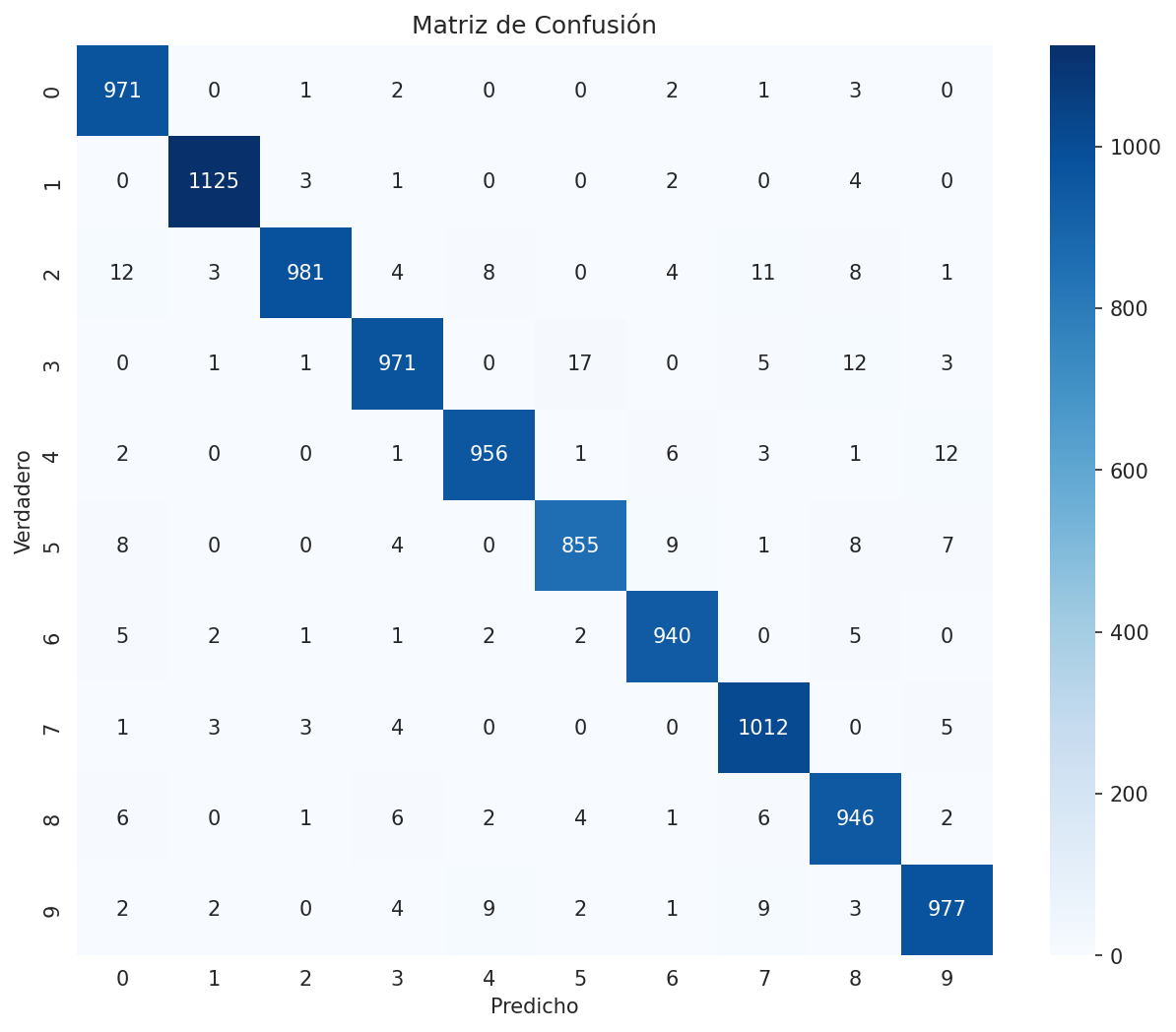

# Matriz de confusión

from sklearn.metrics import confusion_matrix

import seaborn as sns

cm = confusion_matrix(y_test, predicted_classes)

plt.figure(figsize=(10, 8))

sns.heatmap(cm, annot=True, fmt='d', cmap='Blues')

plt.title('Matriz de Confusión')

plt.ylabel('Verdadero')

plt.xlabel('Predicho')

plt.show()

Paso 8: Red Convolucional (CNN) - Para imágenes

# Construir una CNN simple

cnn_model = keras.Sequential([

# Capa convolucional 1

keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

keras.layers.MaxPooling2D((2, 2)),

# Capa convolucional 2

keras.layers.Conv2D(64, (3, 3), activation='relu'),

keras.layers.MaxPooling2D((2, 2)),

# Aplanar y conectar a capas densas

keras.layers.Flatten(),

keras.layers.Dense(64, activation='relu'),

keras.layers.Dropout(0.5), # Regularización

keras.layers.Dense(10, activation='softmax')

])

cnn_model.compile(

optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy']

)

cnn_model.summary()Paso 9: Entrenamiento de la CNN

# Entrenar la CNN

cnn_history = cnn_model.fit(

X_train, y_train_categorical,

epochs=15,

batch_size=32,

validation_split=0.2,

verbose=1

)

# Evaluar CNN

cnn_test_loss, cnn_test_accuracy = cnn_model.evaluate(X_test, y_test_categorical, verbose=0)

print(f"\nPrecisión de la CNN en prueba: {cnn_test_accuracy:.4f}")Paso 10: Regularización y Callbacks

# Añadir callbacks para mejorar el entrenamiento

callbacks = [

keras.callbacks.EarlyStopping(patience=3, restore_best_weights=True),

keras.callbacks.ReduceLROnPlateau(factor=0.1, patience=2)

]

# Modelo con regularización

regularized_model = keras.Sequential([

keras.layers.Flatten(input_shape=(28, 28, 1)),

keras.layers.Dense(128, activation='relu', kernel_regularizer=keras.regularizers.l2(0.001)),

keras.layers.Dropout(0.3),

keras.layers.Dense(64, activation='relu'),

keras.layers.Dropout(0.3),

keras.layers.Dense(10, activation='softmax')

])

regularized_model.compile(

optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy']

)

# Entrenar con callbacks

regularized_history = regularized_model.fit(

X_train, y_train_categorical,

epochs=20,

batch_size=32,

validation_split=0.2,

callbacks=callbacks,

verbose=1

)Paso 11: Guardar y Cargar Modelos

# Guardar modelo

regularized_model.save('mi_primer_modelo.h5')

# Cargar modelo

modelo_cargado = keras.models.load_model('mi_primer_modelo.h5')

# Usar modelo cargado

predictions_cargado = modelo_cargado.predict(X_test[:5])

print(f"Predicciones con modelo cargado: {np.argmax(predictions_cargado, axis=1)}")Paso 12: Experimentación y Próximos Pasos

# Probar diferentes arquitecturas

def crear_modelo_experimental():

model = keras.Sequential([

keras.layers.Flatten(input_shape=(28, 28, 1)),

keras.layers.Dense(256, activation='relu'),

keras.layers.BatchNormalization(),

keras.layers.Dropout(0.4),

keras.layers.Dense(128, activation='relu'),

keras.layers.Dropout(0.3),

keras.layers.Dense(10, activation='softmax')

])

model.compile(

optimizer=keras.optimizers.Adam(learning_rate=0.001),

loss='categorical_crossentropy',

metrics=['accuracy']

)

return model

# Crear y entrenar modelo experimental

modelo_experimental = crear_modelo_experimental()

modelo_experimental.fit(

X_train, y_train_categorical,

epochs=10,

batch_size=64,

validation_split=0.2,

verbose=1

)Paso 13: Consejos para el Éxito con Redes Neuronales

- Empieza Simple: Comienza con arquitecturas básicas

- Preprocesa tus Datos: Normaliza y prepara adecuadamente

- Monitoriza el Entrenamiento: Usa validation split y callbacks

- Experimenta: Prueba diferentes arquitecturas y hiperparámetros

- Regulariza: Usa Dropout y L2 regularization para evitar overfitting

- Aumenta Datos: Considera data augmentation para imágenes

Paso 14: Próximos Pasos en tu Journey

- Redes Convolucionales Avanzadas: ResNet, Inception, EfficientNet

- Redes Recurrentes: LSTM, GRU para series temporales y texto

- Transfer Learning: Usar modelos pre-entrenados

- Autoencoders y GANs: Aprendizaje no supervisado generativo

- Transformers: BERT, GPT para procesamiento de lenguaje natural

Conclusión

¡Felicidades! Ahora dominas los fundamentos de las redes neuronales con TensorFlow/Keras. Practica con tus propios datasets y explora más arquitecturas avanzadas. Si tienes preguntas, déjalas en los comentarios.

Para más tutoriales sobre ciencia de datos y Python, visita nuestra sección de tutoriales.

¡Con estos conocimientos ya puedes construir tus primeras redes neuronales en Python!

💡 Tip Importante

🧠 Mejores Prácticas para Redes Neuronales

Para desarrollar modelos de redes neuronales efectivos, considera estos consejos:

Empieza simple: Comienza con arquitecturas básicas antes de complejas.

Preprocesa adecuadamente: Normaliza datos y usa one-hot encoding para categorías.

Monitoriza el entrenamiento: Usa validation split para detectar overfitting.

Experimenta con hiperparámetros: Prueba diferentes learning rates y arquitecturas.

Regulariza: Usa Dropout y regularización L2 para mejorar generalización.

Usa callbacks: EarlyStopping y ReduceLROnPlateau mejoran el entrenamiento.

Guarda modelos: Usa .save() para persistir modelos entrenados.

Itera: El deep learning requiere experimentación y ajuste continuo.

📚 Documentación: Revisa la documentación completa de TensorFlow/Keras aquí

¡Estos consejos te ayudarán a construir redes neuronales efectivas y robustas!

No hay comentarios aún

Sé el primero en comentar este tutorial.