Atención en Transformers: Cómo Funciona y Por Qué Importa

13 MAR., 2025

//1 min. de Lectura

En el mundo del procesamiento del lenguaje natural (NLP), los Transformers han revolucionado la forma en que las máquinas comprenden y generan texto. Uno de los componentes más cruciales de esta arquitectura es el mecanismo de atención. En este artículo, nosotros exploraremos qué es la atención en los Transformers, cómo funciona y por qué es fundamental para el éxito de estos modelos.

¿Qué es el Mecanismo de Atención?

El mecanismo de atención es una técnica que permite a un modelo enfocarse en diferentes partes de una entrada de datos mientras genera una salida. En lugar de procesar toda la información de manera uniforme, la atención permite que el modelo "preste atención" a las partes más relevantes de la entrada, optimizando así la interpretación y la generación de texto.

Esta técnica fue introducida inicialmente en el contexto de la traducción automática, donde un modelo debía aprender a relacionar palabras en un idioma con sus equivalentes en otro. Sin embargo, su aplicación se ha expandido a otros ámbitos dentro del NLP y más allá, incluyendo tareas como el resumen de texto y la respuesta a preguntas.

¿Cómo Funciona la Atención en Transformers?

Para entender cómo funciona el mecanismo de atención en los Transformers, es crucial desglosar el proceso en varias etapas. Aquí hay un resumen de cómo se lleva a cabo la atención:

1. Cálculo de los Vectores de Atención

La atención en los Transformers se basa en tres componentes clave: las consultas (queries), las claves (keys) y los valores (values). Cada palabra en la secuencia de entrada se convierte en estos tres vectores. Las consultas se utilizan para buscar información relevante, las claves actúan como identificadores y los valores son los datos que se devolverán.

2. Cálculo de las Puntuaciones de Atención

Una vez que se han definido las consultas, claves y valores, se calcula la puntuación de atención. Esta puntuación se obtiene mediante un producto escalar entre las consultas y las claves, que determina cuánta atención debe prestarse a cada parte de la entrada. Las puntuaciones se normalizan utilizando la función softmax, lo que convierte las puntuaciones en probabilidades.

3. Generación del Contexto de Atención

Finalmente, el contexto de atención se genera multiplicando las probabilidades normalizadas por los valores. Este contexto es una representación ponderada de la entrada, donde las partes más relevantes tienen un mayor impacto en la salida del modelo. Este proceso permite que el modelo se enfoque en información crítica y ignore datos menos relevantes.

Importancia del Mecanismo de Atención

El mecanismo de atención es fundamental por varias razones, que nosotros exploraremos a continuación:

1. Captura de Dependencias a Largo Plazo

A diferencia de los modelos anteriores, como las redes neuronales recurrentes (RNN), que a menudo tienen dificultades para capturar dependencias a largo plazo, los Transformers utilizan la atención para conectar palabras distantes en una secuencia de manera efectiva. Esto permite una comprensión más rica del contexto y significa que el modelo puede relacionar conceptos relevantes que no están necesariamente cerca uno del otro en el texto.

2. Procesamiento Paralelo

El mecanismo de atención permite el procesamiento paralelo de datos, lo que acelera significativamente el entrenamiento y la inferencia de los modelos. A diferencia de las RNN, que procesan datos de manera secuencial, los Transformers pueden procesar todas las entradas a la vez, lo que resulta en una mayor eficiencia computacional.

3. Flexibilidad y Adaptabilidad

El uso de atención permite que los Transformers sean altamente flexibles y adaptables a diversas tareas de procesamiento de lenguaje natural. La misma arquitectura se puede utilizar para tareas de traducción, resumen, generación de texto y más, lo que lo convierte en una herramienta versátil en el campo del aprendizaje automático.

Aplicaciones de la Atención en Transformers

La atención en los Transformers ha dado lugar a una variedad de aplicaciones impactantes en el procesamiento del lenguaje natural. A continuación, nosotros discutiremos algunas de las más relevantes:

1. Traducción Automática

La traducción automática ha mejorado significativamente gracias a los modelos que utilizan atención. Estos modelos pueden traducir texto de un idioma a otro con mayor precisión, capturando el contexto y el significado de las palabras de manera más efectiva.

2. Resumen de Texto

Los modelos Transformers también son utilizados para resumir texto largo de manera coherente. Gracias al mecanismo de atención, el modelo puede identificar las partes más importantes del texto y generar un resumen relevante y conciso.

3. Generación de Texto Creativa

La generación de texto creativo, como la escritura de historias o poesía, se ha beneficiado enormemente de los modelos basados en atención. Los Transformers pueden generar texto que es no solo coherente, sino también creativo, al capturar el contexto y la intención detrás de las palabras.

Preguntas Frecuentes (FAQs)

¿Qué es el mecanismo de atención en Transformers?

El mecanismo de atención es una técnica que permite a un modelo enfocarse en diferentes partes de una entrada de datos mientras genera una salida, optimizando así la interpretación y la generación de texto.

¿Por qué es importante la atención en los Transformers?

La atención es importante porque permite a los Transformers capturar dependencias a largo plazo, procesar datos en paralelo y adaptarse a diversas tareas de procesamiento del lenguaje natural.

¿En qué aplicaciones se utilizan los Transformers?

Los Transformers se utilizan en aplicaciones como la traducción automática, el resumen de texto y la generación de texto creativa, entre otras tareas de procesamiento de lenguaje natural.

El mecanismo de atención en los Transformers ha revolucionado el campo del procesamiento del lenguaje natural, permitiendo que las máquinas comprendan y generen texto de manera más efectiva. Gracias a su capacidad para capturar el contexto y las relaciones entre palabras, los Transformers se han convertido en una herramienta esencial en la inteligencia artificial moderna. A medida que continuamos explorando nuevas aplicaciones y mejorando estas tecnologías, el impacto de la atención seguirá creciendo, transformando la forma en que interactuamos con el lenguaje.

Comentarios

0Sin comentarios

Sé el primero en compartir tu opinión.

También te puede interesar

Descubre más contenido relacionado que podría ser de tu interés

T5 de Google: El Modelo "Text-to-Text" que Unifica Todas las Tareas NLP

T5 unifica la traducción, clasificación, resumen y más bajo un mismo paraguas conceptual y técnico

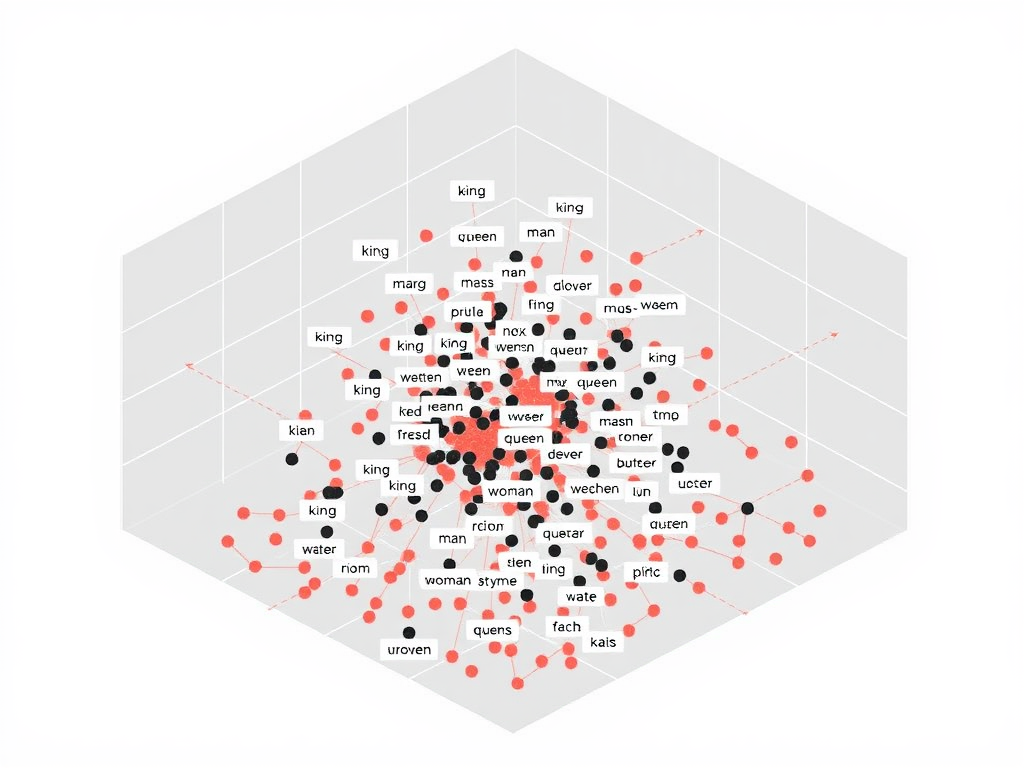

Embeddings y su Impacto en el Procesamiento de Texto

exploraremos qué son los embeddings, cómo funcionan, su impacto en el procesamiento de texto